صاحبان وب سایت برای بهبود رتبه وب سایت خود در موتورهای جستجو، همیشه به دنبال راه هایی هستند که وب سایتشان به لحاظ فنی قابل فهم برای موتورهای جستجو باشد و با منطق های آنها هم راستا باشد. موتورهای جستجوگر برای شناخت و درجه بندی وب سایت ها الگوریتم های متنوعی دارند که همه صاحبان وب سایت ها و همچنین افرادی که در زمینه سئو فعالیت دارند باید با این الگوریتم ها آشنایی کامل داشته باشند. در این میان یادگیری الگوریتم های گوگل از اهمیت بالاتری برخوردار است.

الگوریتم چیست؟

در یک تعریف عمومی به مجموعه ای از دستور العمل ها و فرمول هایی که با زبان رسا و دقیق به همراه جزئیات لازم و به صورت مرحله به مرحله به گونه اجرا شده باشند که هدف خاصی را دنبال کنند و شروع و پایان آنها نیز مشخص باشد، الگوریتم گفته می شود.

الگوریتم گوگل چیست؟

الگوریتم های گوگل دستورالعمل هایی هستند که موتور جستجوی گوگل بر اساس آن تجزیه و تحلیل وب سایت ها را انجام می دهند. الگوریتم های گوگل شامل معادلات گوناگون و متفاوت و تابع است که برای کاربر نمایش داده شود. خزنده موتور های جستجو همه اطلاعات و داده ها را گرد آوری کرده و ذخیره و نگهداری می نماید. در حقیقت اگوریتم ها به شکل ریاضی می باشند که محتویات و اطلاعات توسط آنها طبقه بندی می شود تا در مواقع لازم کاربران بتوانند از این داده ها استفاده کنند.

در نظر داشته باشید که طبق اعلام گوگل، وزن الگوریتم های هسته در سال ۵۰۰ بار تغییر می کند و گوگل بیش از ۲۰۰ فاکتور را برای اندازه گیری قدرت صفحات اینترنتی در نظر می گیرد. به همین دلیل است که نتایج گوگل همواره در حال تغییر هستند و گوگل همواره سعی می کند بهترین نتیجه را به کاربر نمایش دهد. در نتایج گوگل، علایق کاربر، مکان فیزیکی و فاکتور های بسیار زیاد دیگری نیز دخیل هستند تا بتوانند نتایج را شخصی سازی کنند.

دنیای سئو مدام در حال تغییر است و فاکتور هایی که برای رتبه بندی سایت ها در صفحه نتایج موتورهای جستجو استفاده می شود نیز همیشه ثابت نمی ماند. گوگل به عنوان پرکاربردترین موتور جستجوی اینترنتی تاکنون بارها الگوریتم های رتبه بندی خود را تغییر داده و به روز رسانی کرده است. چون گوگل در بازار جستجوی اینترنتی نفوذ و انحصار زیادی دارد، آگاهی از به روزرسانی الگوریتم های رتبه بندی اش امری ضروری است، زیرا در صورت همسو نشدن با آن ممکن است رتبه سایت ها در صفحه نتایج جستجوی گوگل افت کند و موجب کاهش ترافیک ورودی به آن ها شود. در ادامه به بررسی و تشریح عملکرد چند مورد از الگوریتم های گوگل می پردازیم.

معرفی الگوریتم های گوگل:

الگوریتم پنگوئن گوگل (Penguin algorithm):

الگوریتم پنگوئن در آوریل ۲۰۱۲ معرفی گردید که بر روی لینک های سایت و بک لینک ها تمرکز دارد. این الگوریتم وظیفه شناسایی لینک های اسپم و سایت هایی را که برای بهبود رنکینگ خود بک لینک خریداری می کنند به عهده دارد. همانطور که میدانیم گوگل برای سایتی که تعداد لینک ورودی به آن از سایت های دیگر بیشتر باشد امتیاز بالاتری قائل شده و آن را در رتبه های بالاتر جستجو قرار می دهد. این عمل باعث شده تا افرادی سودجو به صورت فله ای اقدام به قرار دادن لینک وب سایت های دیگر کرده و بابت آن پول دریافت کنند. پنگوئن گوگل در صورت مواجه با تعداد زیاد لینک گذاری در یک سایت و مرتبط نبودن لینک های قرارداده شده با محتوای آن سایت، اسپمرها را شناسایی نموده و هم وب سایت لینک گذارنده و هم وب سایت لینک دهنده را جریمه و از لیست جستجوها حذف می کند.

گوگل در مقابل به قدرت و اهمیتی که بک لینک ها دارند امتیاز می دهد و به همین دلیل بهترین کار نگارش مطالب خوب و مفید و انتشار آن در شبکه های اجتماعی است که می توانند بک لینک های خوبی را برای شما به ارمغان بیاورد. موضوع دیگری که در الگوریتم های گوگل اهمیت دارد anchor text می باشد. Anchor text متنی است که برای توضیح و نمایش لینک استفاده می شود.

چرا الگوریتم پنگوئن تشکیل شد؟

- مبارزه با اسپمر ها و مطالب کپی

- استفاده بیش از حد از کلمه کلیدی

نمونه هایی از لینک های غیر طبیعی:

- لینک های خریده شده برای بدست آوردن رتبه

- تبادل لینک بیش از حد به صورت متقابل

- لینک های ایجاد شده به صورت خودکار با برنامه های لینک ساز

فاکتور های مورد بررسی الگوریتم پنگوئن:

- میزان به اشتراک گذاشته شدن مطالب شما در شبکه های اجتماعی

- پرهیز از تکرار کلمات کلیدی

- کیفیت مطالب موجود در وب سایت

- عدم استفاده از مطالب کپی و رعایت کپی رایت

- منظم قرار دادن مطالب وب سایت

- محتوای به صورت اتوماتیک تولید شده

- پنهان کاری

- تغییر مسیر های فریب کارانه

- متن یا لینک پنهانی

- صفحات راه در رو

- بارگذاری صفحات با کلمات کلیدی بی ربط

- ایجاد صفحات با رفتارهای مخرب مانند فیشینگ، نصب ویروس ها، تروجان ها یا دیگر بدافزارها

- سوء استفاده از تکه های غنی نشانه گذاری شده

- ارسال پرس و جو های خودکار به گوگل

الگوریتم پنگوئن ۴.۰

پس از دو سال انتظار، الگوریتم پنگوئن گوگل بالاخره به روز رسانی شد و سئو کاران بسیاری به این موضوع واکنش نشان دادند. این چهارمین به روزرسانی بزرگی است که گوگل بر روی الگوریتم پنگوئن خود اعمال می کند.

گوگل بیان کرده است که دیگر به روزرسانی های الگوریتم پنگوئن را اعلام نمی کند. از آنجایی که الگوریتم پنگوئن نسخه ۴٫۰ به صورت لحظه ای کار می کند و دائماً در حال فعالیت است، دیگر نیازی به تایید به روزرسانی ها وجود ندارد.

نکات مهم در خصوص الگوریتم پنگوئن ۴.۰:

الگوریتم پنگوئن گوگل به صورت لحظه ای (Real-Time) کار می کند.

پنگوئن نسخه ۴ به صورت لحظه ای (Real Time) سیگنال های مرتبط با رتبه بندی را پردازش می کند. همانطور که الگوریتم جستجوی گوگل دائماً در حال Crawl و Index وب سایت ها است، الگوریتم پنگوئن نیز در همان لحظه، فاکتور های موجود در وب سایت ها را بررسی می کند. طی این فرآیند منظم، سایت ها ممکن است جریمه شوند یا از جریمه رهایی پیدا کنند.

پیوستن به هسته مرکزی:

همچنین گفته می شود که این آپدیت، آخرین به روز رسانی است که الگوریتم پنگوئن دریافت می کند چرا که از این پس الگوریتم پنگوئن به عنوان بخشی از هسته مرکزی الگوریتم جستجوی گوگل فعالیت می کند.

تمرکز بیشتر پنگوئن (صفحات به جای کل سایت):

گوگل همچنین بیان کرده است که الگوریتم جدید پنگوئن بسیار جزئی تر و دقیق تر عمل کند. اینکه الگوریتم پنگوئن گوگل بیش از پیش دقیق تر (Granular) شده است بدین معناست که تک تک صفحات موجود در سایت را بررسی می کند و به جای تاثیر بر روی رنک کلی سایت، صفحه حاوی اسپم را شناسایی می کند.

دامنه تاثیر گذاری پنگوئن ۴.۰:

اگر چند مورد از صفحات سایت شما دارای لینک های نامناسب یا اسپمی باشند و تعداد این صفحات نسبت به کل صفحات سایت شما عدد بزرگی نباشد (یعنی مثلا سایت شما ۲ صفحه نباشد و ۱ صفحه از آن لینک های اسپمی داشته باشد)، می توانید انتظار داشته باشید که فقط همان صفحات ناچیز از نتایج حذف شوند.

به روز رسانی الگوریتم پنگوئن گوگل:

در سال ۲۰۱۲، گوگل به روز رسانی پنگوئن را برای رفع سوء استفاده گسترده از کلمات کلیدی و لینک ها منتشر کرد. پیش از این به روز رسانی، سایت ها می توانستند رتبه بندی نتایج جستجوی خود را با ایجاد لینک به سایر وب سایت های محبوب افزایش دهند. آنها همچنین می توانستند موتور جستجو را از طریق keyword stuffing فریب دهند. keyword stuffing یعنی اضافه کردن ییش از حد کلمات کلیدی به متن به طوری که آن متن غیر طبیعی باشد و هیچ ارزش واقعی برای خواننده ارائه نکند.

به روز رسانی پنگوئن به ایجاد لینک طبیعی به منابع معتبر، مرتبط و همچنین قرار دادن استراتژیک کلمات کلیدی مرتبط امتیاز می دهد. اگر شما از منابع معتبر در محتوای عمیق خود استفاده کنید، رتبه وب سایت خود در نتایج جستجوی گوگل را بهبود می دهید. اگر از کلمات کلیدی مناسب استفاده کنید و از این کلمات کلیدی بیش از حد استاندارد استفاده نکنید، رتبه سایت خود در نتایج جستجوی گوگل حتی بیشتر خواهد شد.

یک نکته حائز اهمیت دیگر توجه به سایت هایی است که به شما لینک داده اند. چرا که یکی دیگر از به روز رسانی های پنگوئن، سبب شده است که اگر سایت های اسپم لینک هایی به یک وب سایت ایجاد کنند، آن سایت جریمه شود. بر سایت هایی که به وب سایت شما لینک داده اند نظارت کنید و اگر آنها از اعتبار کافی برخوردار نبودند، از ابزار Google BackLinks Disavow استفاده کنید تا لینک را قطع کنید.

الگوریتم پاندا گوگل (Panda algorithm):

الگوریتم پاندا وظیفه شناسایی محتوای نامناسب و کپی شده از سایت های دیگر و روش های تقلب در داخل سایت مانند cloacking (نمایش محتوایی مغایر با آنچه در موتور جستجوگر نمایش داده شده) و… را به عهده دارد و با این کار سایت های با کیفیت پایین را از لیست جستجوها حذف و سایت های کیفیت بالا را جایگزین آن ها می کند. پاندا دائما به دنبال مطالب دست اول و تولیدی توسط خود صاحبان وب سایت ها می باشد و نسبت به ارتقای رتبه چنین سایت هایی اقدام می کند و در عوض رتبه سایت هایی را که فقط مطالب سایت های دیگر را کپی برداری می کنند تنزل می دهد.

شاخصه های مد نظر پاندا:

در مورد شاخصه های مدنظر پاندا باید به تفصیل سخن گفت. اما می توان به طور کلی و خلاصه به مواردی که در مدیریت یک وب سایت باید از آنها فاصله گرفت را به شرح زیر بر شمرد:

- استفاده بیش از حد از تبلیغات

- متاتگ ها و تگ های نامناسب در وب سایت

- استفاده بیش از حد از یک تگ یا تگ های نامربوط در یک صفحه

- لینک های شکسته (به طور مثال لینک هایی که به خطای ۴۰۴ منتهی می شوند)

- وجود محتوای کیفیت پایین در کل وب سایت یا بخشی از آن

- زمان کوتاه حضور هر کاربر بر روی وب سایت

- مشکلات فنی وب سایت

- استفاده از قالب های آماده

چک لیستی برای تعیین کیفیت محتوای وب سایت:

- آیا شما به اطلاعات ارائه شده در این مقاله اعتماد کردید؟

- آیا این مقاله توسط یک متخصص و یا یک علاقمند آشنا با موضوع آن نوشته شده و یا این مقاله در اصل و طبیعت آن کم عمق و ضعیف است؟

- آیا سایت تکراری است، شامل تداخل می باشد و یا مقالات زائد و بی فایده با موضوعات یکسان یا مشابه همراه با تغییرات جزئی کلمات کلیدی متفاوت می باشد؟

- آیا در درج اطلاعات کارت های بانکی برای پرداخت آنلاین راحت بودید؟

- آیا این مقاله اشتباهات املایی، خطاهای کوچک و یا واقعی دارد؟

- آیا این موضوعات بر اساس منافع واقعی خوانندگان وب سایت تولید شده اند یا توسط سایت های تولید محتوا بر اساس حدس جهت ارتقا در موتورهای جستجو می باشند؟

سوالاتی که برای رعایت الگوریتم پاندا از خود بپرسیم؟

- آیا این مقاله محتوا و اطلاعات اورجینال، گزارش اورجینال، تحقیقات اورجینال، یا تجزیه و تحلیل اورجینال را ارائه می کند؟

- آیا این صفحه ارزش قابل توجه و خوبی در مقایسه با دیگر صفحات در نتایج جستجو ارائه می کند؟

- چقدر کنترل کیفیت بر روی محتوا انجام می شود؟

- آیا این مقاله دو سمت یک داستان را توصیف می کند (بی طرفانه می باشد)؟

- آیا این سایت یک مرجع و مولف شناخته شده در مورد این موضوع می باشد؟

- آیا محتوا تولید انبوه شده است و یا برون سپاری شده به تعداد زیادی از سازندگان و یا در سراسر یک شبکه بزرگ از سایت ها گسترش یافته، به طوری که به آن صفحات منحصر به فرد یا سایت ها توجه یا مراقبت زیادی نمی شود؟

- آیا مقاله به خوبی ویرایش شده یا به نظر درهم و برهم می آید و با عجله تولید شده است؟

- برای یک پرس و جو مهم مرتبط، به اطلاعات این سایت اعتماد می کنید؟

- آیا شما این سایت را به عنوان یک منبع معتبر می شناسید در زمانی که نامش بیان می شود؟

- آیا این مقاله توضیحات کامل و جامعی از موضوع ارائه می کند؟

- آیا این مقاله شامل تجزیه و تحلیل های روشن و خردمندانه و یا اطلاعات جالب می باشد که واضح و آشکار است؟

- آیا این صفحه از نوع صفحاتی می باشد که شما آن را نشانه گذاری (bookmark) می کنید، با دوست خود به اشتراک می گذارید یا این صفحه را پیشنهاد می کنید؟

- آیا این مقاله محتوی مقدار بیش از حد از تبلیغات می باشد که منجر به منحرف کردن و یا تداخل با محتوای اصلی می شود؟

- آیا انتظار دارید که این مقاله را در یک مجله چاپ شده، یک دانشنامه و یا یک کتاب ببینید؟

- آیا این مقاله کوتاه، بی اساس و یا در غیر اینصورت فاقد جزئیات مفید می باشد؟

- آیا این مقاله با دقت فراوان و توجه به جزئیات تولید شده و یا با توجه کمتر به جزئیات؟

- آیا کاربران زمانی که صفحات این سایت را ببیند، شکایت می کنند؟

لیست بالا بسیار سخت و طاقت فرسا می باشد. این پرسش ها لزوما به این معنی نیست که گوگل تلاش می کند توسط الگوریتم هایش بفهمد که مقالات شما جالب و یا عادلانه هستند. در عوض این پرسش ها می توانند کمک کنند تا میزان امتیازدهی کاربرای واقعی به کیفیت سایت شما مشخص شود. هیچ کس واقعا همه فاکتور ها و عواملی که گوگل برای تعیین کیفیت سایت شما از طریق پاندا استفاده می کند را نمی داند.

نکته مهم آنکه اکنون دیگر زمان فریب گوگل با استفاده از ترفندهای خاص بهینه سازی به پایان رسیده است. بدون شک پاندای گوگل باهوش تر از همیشه در بالاترین نقطه الگوریتم جستجوی گوگل نشسته و بر عملکرد سایت ها و گردانندگان آن نظارت می کند.

امتیاز ما در گوگل به چه عواملی بستگی دارد؟

- تعداد بازدید ها (Number Hits)

- کیفیت محتوا (Quality Of Content)

- مدت زمان ماندگاری مخاطب در سایت شما (Time On Site)

چه عواملی باعث می شود ما نزد گوگل پاندا محبوب شویم؟

- زمان قرار داشتن مخاطب در سایت شما (Time On Site)

- میزان مشاهده از دیگر صفحات سایت شما (Page Views)

- میزان فراری بودن از سایت (Bounce Rate)

- اشتراک گذاری مطالب در شبکه های اجتماعی (Social Networks)

- برند سازی اینترنتی (Internet Branding)

به روز رسانی الگوریتم پاندا گوگل:

در سال ۲۰۱۴، گوگل هشت مورد از تغییرات الگوریتم موتور جستجو را منتشر کرد. همه این تغییرات بخشی از به روز رسانی پاندا نامیده می شود.

تفاوت بین هر یک از تغییرات جزئی الگوریتم های گوگل بسیار منحصر به فرد است. با این حال، همه این تغییرات اهداف مشابهی داشتند: کاهش رتبه بندی محتوای سبک، ضعیف و کمتر مفید در نتایج جستجوی گوگل.

به روز رسانی پاندا اساسا یک فیلتر محتوا، از بین برنده محتوای بد، هرزنامه و تبلیغ محتوای عمیق است. به منظور ماندن در بالای نتایج جستجوی گوگل، شما باید به طور مداوم محتوای وب با ارزش و مفیدی که به سوالات مخاطبان شما پاسخ می دهد، ایجاد کنید. این محتوا باید مختصر، بدون خطاهای دستوری و با استثناهای بسیار کم باشد و هرگز مطالب تکراری در آن به کار برده نشده باشد. منابع مورد استفاده نیز باید قابل اعتماد باشند.

الگوریتم مرغ مگس خوار گوگل (Hummingbird algorithm):

این الگوریتم در اصل افزونه ای است که کار تجزیه و تحلیل عباراتی را که کاربر برای جستجو وارد کرده به عهده دارد تا گوگل با این کار بتواند نتایج بهتری را به کاربران نمایش داده و نتایج خود را بهبود بخشد. در واقع این الگوریتم تاثیر مستقیمی در نتایج رتبه بندی ندارد و صرفا عباراتی را که کاربر جستجو کرده بررسی می کند و بر اساس خواسته های کاربر سعی می کند بهترین نتیجه را نمایش دهد.

تفاوت روش جستجو بر اساس کلمه کلیدی و تحلیل کلمه در چیست؟

در گذشته نتایج جستجو صفحاتی را شامل می شد که در متن خود از کلمه کلیدی جستجو شده و عبارت مورد نظر بهره می برد. به طور مثال کاربر” کامپیوتر ”را جستجو می کند سپس گوگل صفحاتی را که در محتوای آن از کلمه” کامپیوتر ”بهره می برد به نمایش می گذارد. اما امروزه با استفاده از مرغ مگس خوار علاوه بر کلمه کلیدی، برمفهوم آن و متنی که به کلمه کلیدی مربوط می شود هم دقت کرده و به سرعت صفحاتی را که بیشترین ارتباط با کلمه جستجو شده دارند برای کاربر لیست و به نمایش در می آورد.

به عنوان مثال هنگام جستجوی” کامپیوتر ”در الگوریتم جدید، صفحاتی لیست می شود که در متن آن از کامپیوتر، رایانه و تمام عباراتی که مترادف با” کامپیوتر ”می باشد استفاده کرده و در نتیجه کاربر صفحاتی را مشاهده می نماید که بیشترین ارتباط را با عبارت جستجو شده ی خود دارد.

در روش جستجو بر اساس کلمه کلیدی، کاربر گاهاً شاهد آن بود که نتایج متفاوت با عبارت مورد نظرش می باشد. در این روش تمام کلمات و حتی حروف اضافه عیناً مورد بررسی قرار می گرفت به طور مثال اگر در عبارت جستجو “از”، “را” و غیره را به کار بریم موتور جستجو آنها را نیز به عنوان کلمه کلیدی در نظر می گرفت. در نتیجه کاربر شاهد محتوایی بود که از هدفش فاصله دارد به همین منظور می توان پدید آمدن این اتفاق را از مشکلات و معایب این روش در نظر گرفت.

اما در روش جستجوی تحلیلی (استفاده از مرغ مگس خوار) صفحاتی که در نتایج گوگل برای کاربر لیست می شود کاملا مرتبط با عبارت جستجو شده بوده و کاربر با بیشترین سرعت به بهترین نتایج دست خواهد یافت.

به روز رسانی الگوریتم مرغ مگس خوار گوگل:

در سال ۲۰۱۵ مدیران گوگل متوجه شدند که بسیاری از پرس و جوهای جستجو شامل عبارات و سوالات مکالمه ای است. برای کمک به این موضوع که کاربران به جای مشاهده نتایج بر مبنای کلمات کلیدی خاص، آنچه که دقیقا در نظر دارند را بیابند، به روز رسانی مرغ مگس خوار منتشر شد.

با توجه به تمرکز مرغ مگس خوار بر زبان مکالمه ای، این الگوریتم برای کلمات کلیدی طولانی که در جستجوی هدفمند کاربر مفید واقع می شود، مزیت قائل می شود. به عنوان مثال، در دوران پس از مرغ مگس خوار، محتوای با کلمه کلیدی، “چگونه می توان ایمیل ساخت”، بهتر از محتوا با کلمه کلیدی، “ساختن ایمیل”عمل می کند.

در نتیجه، نحوه نوشتن مقالات و دیگر محتوای وب به سبک آموزشی بیشتر شایع شده است و کاربران قادر هستند محتوای آموزنده را بسیار ساده تر پیدا کنند. بر خلاف به روز رسانی های پاندا و پنگوئن، به روز رسانی مرغ مگس خوار بر جریمه و یا استفاده از روش های خاص برای کاهش رتبه بندی جستجو تمرکز نمی کند.

الگوریتم کبوتر گوگل (Pigeon algorithm):

قطب اصلی موتور جستجوی گوگل الگوریتم کبوتر است. سئوی محلی یا local SEO مدت هاست که مورد توجه موتورهای جستجو و به ویژه گوگل بوده است. در این روش نتایج جستجو متناسب با محل جغرافیایی کاربر تعیین می شوند.

هنوز هیچ نام مشخصی برای این الگوریتم جدید از طرف گوگل معرفی نشده و وبمستران نام کبوتر یا Pigeon را برای آن انتخاب کرده اند. نام الگوریتم کبوتر به این دلیل انتخاب شده است که در گذشته کبوترها برای ارتباطات محلی و نزدیک استفاده می شدند.

گوگل اعلام کرده است که الگوریتم کبوتر استفاده بهتری از توانایی های اطلاعاتی گوگل کرده و صدها عامل را در رتبه بندی نتایج جستجو در نظر خواهد گرفت. به ویژه استفاده از اطلاعاتی شامل کلمات مشابه، غلط های املایی کاربران، تخمین محل و فاصله از توانایی های این الگوریتم جدید خواهند بود.

اطلاعات وب سایت های اینترنتی در قفس های داده قرار می گیرند و در هر قفس تعدادی کبوتر وجود دارد که به بررسی محتوای این سایت ها و مقایسه آن ها با کلمه کلیدی جستجو شده می پردازند. هر بار که مطلبی مناسب کلمه کلیدی پیدا کنند یک بار به آن نوک می زنند. صفحاتی که بیشترین مقدار نوک به آنها خورده شده باشد در گوگل بالاتر نشان داده می شوند. ضمنا این الگوریتم به محلی کردن نتایج جستجو نیز کمک زیادی می کند.

به این ترتیب که با در نظر گرفتن محل سکونت فرد جستجو کننده نتایجی را به او نشان می دهد که به محل سکونتش نزدیک تر باشد. به عنوان مقال می توان از لیست کردن مغازه های فروش ابزار آلات که در یک محله قرار دارند، نام برد.

الگوریتم کبوتر در حال حاضر تنها برای جستجوهایی که به زبان انگلیسی انجام می شوند فعال شده و هنوز اطلاعاتی در مورد زمان راه اندازی آن بر روی تمامی زبان ها شامل زبان فارسی ارائه نکرده است. همچنین میزان تاثیر آن بر نتایج جستجو و درصد سایت هایی که شاهد تغییراتی در بازدید خود خواهند بود در حال حاضر مشخص نمی باشد.

الگوریتم رنک برین گوگل (RankBrain algorithm):

گوگل در سال های اخیر مدام تلاش کرده است تا تجربه کاربری موتور جستجوی خود را بهبود بخشیده و نتایج جستجوی با کیفیتی را به کاربرانش نمایش دهد. به طور کلی گوگل در تلاش است تا معیارهای رتبه گیری سایت ها در صفحه نتایج جستجوی خود را بیشتر به سمت فاکتور های کیفی و کاربر پسند سوق دهد و از ورود سایت هایی با محتوای ضعیف به صدر نتایج جستجو جلوگیری کند. یکی از جدیدترین اقدامات گوگل در این خصوص معرفی الگوریتم رنک برین (RankBrain) است.

الگوریتم رنک برین (RankBrain) که گوگل آن را در اواخر اکتبر سال ۲۰۱۵ معرفی نمود، یک سیستم هوش مصنوعی است که از الگوریتم های یادگیری ماشین (machine learning) استفاده می کند. الگوریتم های یادگیری ماشین به کامپیوترها (مفهوم کلی) امکان می دهد که از طریق دادهها و آزمایشاتی که انجام می دهند، یادگیری در مورد شرایط سیستم بدست آورند و عملکرد خود را به تدریج بهبود دهند. این الگوریتم ها به گوگل کمک می کند تا عبارات جستجو را بهتر پردازش کرده و نتایج مناسب تری را به کاربران خود نمایش دهد. گوگل الگوریتم رنک برین (RankBrain) را به عنوان سومین فاکتور مهم (بعد از بک لینک و محتوا) برای رتبه بندی سایت ها در صفحه نتایج موتور جستجوی خود معرفی کرده است.

آیا الگوریتم رنک برین (RankBrain) تاثیر زیادی بر رتبه سایت ها خواهد گذاشت؟

طبق نظر متخصصان سئو این الگوریتم مطمئنا رتبه سایت ها را در آینده به شدت تحت تاثیر قرار خواهد داد. اما هم اکنون مهندسان گوگل بیشتر بر روی آزمایش این الگوریتم متمرکز هستند و کاربران طی ماه های آتی به مرور تاثیرات آن را در نتایج جستجو خواهند دید. رنک برین (RankBrain) به دلیل استفاده از الگوریتم های یادگیری ماشین قادر خواهد بود تا معنای عبارات و واژه ها را بهتر تشخیص داده (پیشرفته تر از الگوریتم مرغ مگس خوار) و با بازخوردی که از کاربران گوگل دریافت میکند، نتایجی را به آنها نمایش دهد که بیشترین شباهت را به چیزی که آنها دنبالش بوده اند داشته باشد. در واقع این الگوریتم به گوگل کمک میکند تا حدس های بهتری از نظر معنایی در خصوص عبارات جستجو کاربران بزند.

آیا الگوریتم رنک برین (RankBrain) اصول قبلی سئو را تغییر می دهد؟

اصول سئو به دلیل معرفی این الگوریتم تغییر نخواهد کرد، بلکه مسئله اصلی تغییر استراتژی های سئو و بهبود رتبه سایت ها است. برای مثال اگر قبلا چگالی کلمات کلیدی موجود در صفحه، استفاده از کلمات کلیدی در تیترها و لینک ها و … مهم بود، در آینده کیفیت محتوای صفحه، کاربر پسند بودن، مفید، جدید و طبیعی بودن آن اهمیت پیدا خواهد کرد. نکته چالش برانگیز این است که راه مشخصی برای بهبود رتبه سایت به آن شکلی که در گذشته وجود داشت، در آینده وجود نخواهد داشت.

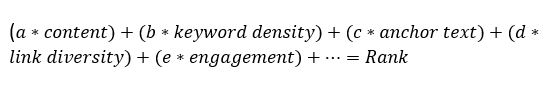

برای درک بهتر این نکته به مثال زیر توجه کنید. اگر رتبه سایت را همانطور که گوگل توصیف میکند، تحت تاثیر ۲۰۰ فاکتور در نظر بگیریم، در گذشته وزن این فاکتور ها به طور تقریبی مشخص بود اما وزن این فاکتور ها در آینده با توجه به نوع عبارات جستجو و سایت های ارائه دهنده محتوا، تغییر خواهند کرد. برای مثل ممکن است دو سایت مشابه برای رسیدن به رتبه ۱ به ازای یک کلید واژه نیاز به بک لینک بیشتر داشته باشند، اما دو سایت دیگر برای کلید واژه ای دیگر به جای تعداد بک لینک بیشتر نیاز به محتوایی تخصصی تر داشته باشند.

رتبه بندی سایت ها در گذشته:

رتبه بندی سایت ها در آینده:

شاید در ابتدا این الگوریتم و میزان تاثیرش بر رتبه سایت ها ترسناک باشد. اما طبق نظر کارشناسان سئو تمام این اقدامات گوگل تنها یک هدف را دنبال میکند و آن ارائه محتوای با کیفیت به کاربران است. در واقع الگوریتم رنک برین (RankBrain) می خواهد کاری که سایر الگوریتم های گوگل در خصوص رتبه بندی (پاندا، پنگوئن، مرغ مگس خوار، کبوتر و …) انجام میدادند را با کمی تغییرات و با پیچیدگی و دقت بیشتری انجام دهد. مزیت این الگوریتم یادگیری و بهبود مستمر آن در طول انجام جستجو و نمایش نتایج است.

الگوریتم طرح بندی گوگل (Page Layout algorithm):

طرح بندی یا پیج لایوت الگوریتم وسیعی مانند پاندا و یا پنگوئن نیست بلکه این الگوریتم ایجاد شده است که سایت هایی که تبلیغات آزار دهنده در سایت خود دارد جریمه کند. مانند تبلیغات پاپ آب، تبلیغات بین پست ها، تبلیغات فلشی که در کناره های سایت قرار دارد. این تبلیغات علاوه بر غیر حرفه ای بودن و جریمه شدن توسط گوگل عواملی مانند کاهش سرعت و انعطاف پذیری سایت، کاهش محبوبیت نزد گوگل، آزار مخاطب و کاهش بازدید کننده را به همراه دارد.

چرا الگوریتم طرح بندی تشکیل شد؟

- مکان تبلیغات در سایت های خود را هوشمندانه انتخاب کنید.

- حجم تصاویر خود را کم کنید.

گوگل با آپدیت الگوریتم طرح بندی خود، به نوعی به مدیران سایت ها و وب مسترها هشدار داد که از تبلیغات بسیار زیاد در سایت جلوگیری کنند.

هدف گوگل از این آپدیت این است که به محتوای سایت خود نسبت به تبلیغات، بیشتر اهمیت بدهید و کاری کنید که کاربران جذب محتوای شما باشند. تا به حال مشاهده کرده اید که سایتی را در گوگل جستجو می کنید و وارد آن می شوید، اما به دلیل اینکه سایت مورد نظر دارای تبلیغات بسیار زیادی است، باید تمام سایت را بگردید تا محتوای مورد نظر خود را از سایت پیدا کنید. گوگل امروزه با این نوع سایت ها برخورد جدی می کند.

گوگل این الگوریتم را بر اساس نظرات و خواسته های کاربران خود که در مدت های گذشته، پیغام هایی برای شکایت از این سایت ها داده بودند، ایجاد و به روز رسانی کرد. کاربران از وجود یک جنگل لینک و تبلیغات در سایت خسته می شوند، از این پس گوگل این خستگی را می فهمد و رتبه سایت مورد نظر را شدیدا کاهش خواهد داد.

این الگوریتم گوگل در سایت هایی که تبلیغات بسیار زیادی ندارند، هیچگونه تاثیری نخواهد گذاشت، چرا که تبلیغات یکی از اصول اینترنت و تجارت الکترونیک می باشد. تنها هدف گوگل این است که زمانی که کاربر وارد سایت شما می شود بدون هیچگونه تکان دادن اسکرول (scrolling) محتوای شما را مشاهده کند.

گوگل از شما رعایت عناصر زیر را می خواهد:

به طراحی بی اعتنایی نکنید.

اگر شما با سایتی که در هم بر هم و بسیار شلوغ است و در این صفحه شلوغ تبلیغات زیادی وجود دارد، انتظار اعتماد کاربران را به خود دارید کاملا در اشتباه هستید. قرار دادن تبلیغات در هدر سایت تنها در صورتی ممکن می شود که شما از آن ها به صورت هوشمندانه استفاده کرده اید و اگر شما در بالای سایت خود از تبلیغات بزرگ و برجسته ای استفاده کرده اید مطمئن باشید که گوگل با شما برخورد خواهد کرد. به عبارتی دیگر، گوگل به طراحی سایت نیز رتبه می دهد.

اسلایدر ها مورد هدف این الگوریتم نیست.

اسلایدر ها و معمولا عناصری که با استفاده از جاوا اسکریپت ایجاد می شوند، گوگل آن ها را مورد تاثیر قرار نخواهد داد، به عبارتی دیگر Page Layout Algorithm کاری به کارجاوا اسکریپت ندارد.

این را هم بدانید که گوگل اعلام کرده است که از بین هر ۱۰۰ سایت، ۱ سایت مورد هجوم این الگوریتم قرار گرفته است.

الگوریتم پی دی لون گوگل (PayDay Loan algorithm):

این الگوریتم برای مبارزه با سایت هایی که از کلمات کلیدی پرکاربرد برای سایتشان استفاده می کنند و در عمل به نوعی کار اسپم انجام می دهند، طراحی شده است. به این گونه که سایت هایی که مطالبشان با کلمات کلیدی که تعیین نموده اند و معمولا جزء کلمات کلیدی پر استفاده قرار دارند شناسایی شده و از لیست جستجوها حذف می گردند.

طبق آخرین خبری که از گوگل اعلام شده است، این الگوریتم همه نتایج در همه کشورها و به همه زبان ها را فرا می گیرد و تاثیر آن بر نتایج با زبان های مختلف فرق دارد و به طور مثال ۰٫۲ درصد نتایج به زبان انگلیسی را شامل می شود .

Matt Cutts سرپرست تحقیقات الگوریتم های گوگل در زمینه اسپم ها هم گفته که این الگوریتم فقط برای کاربران آمریکایی نیست و تمام جستجوهای جهانی گوگل را شامل می شود. جالب است بدانید که این الگوریتم ۰٫۳ درصد از نتایج جستجو شده در منطقه آمریکا را شامل می شود، در حالی که در ترکیه این مقدار حدود ۴ درصد می باشد. گفته شده که سایت های اسپم در بین سایت های ترکی بسیار زیاد هستند.

جالب است بدانید اسم این الگوریتم از نوع خاصی وام که در آمریکا طرفدار زیادی دارد گرفته شده است و در ابتدا برای مقابله با سایت های اسپم در این زمینه ایجاد شده است.

نسخه ۳ این الگوریتم به تازگی منتشر شده است و در آن با کلمات مانند قرص های جنسی و کازینو که از آن ها بیشتر برای اسپم استفاده می کنند، برخورد شدیدتر می کند.

الگوریتم کافئین گوگل (Caffeine algorithm):

این الگوریتم مانند مرغ مگس خوار است و روی عبارات جستجو شده برای بهبود بخشیدن جستجوها به وجود آمده است، با این تفاوت که نگاهش روی شبکه های اجتماعی نیز هست. بنابراین در حال حاضر فعالیت در شبکه های اجتماعی به میزان زیادی روی سئوی سایت تاثیر مثبت دارد.

آنچه برای گوگل اهمیت زیادی دارد، محتوای سایت است. از این رو تولید محتوا یک امر حیاتی در بهینه سازی وب سایت می باشد. گاهی وب مسترها برای بهینه سازی سایت خود، اقدام به آنالیز سایت می کنند که در آن تغییراتی در قسمت محتوا صورت می گیرد. در این صورت گوگل باید متوجه تغییرات صورت گرفته در وب سایت باشد و بدین منظور از الگوریتم کافئین استفاده می کند.

با استفاده از الگوریتم کافئین، گوگل بطور مداوم در وب در حال جستجو است. در این صورت وب سایت ها را در کمترین زمان ممکن ایندکس می کند. گوگل در گذشته برای نشان دادن صفحه نتایج از سیستم index استفاده میکرد. در حالی که اکنون به جای آن کافئین را مورد استفاده قرار داده است. سیستم ایندکس گوگل به صفحات موجود در فهرست خود رجوع می کند. در حالی که کافئین به صورت Live انجام می شود.

نحوه عملکرد الگوریتم کافئین:

کافئین در هر ثانیه صدها هزار صفحه را در فهرست خود به روز رسانی می کند و برای کاربران و امکان جستجوی Live را با جستجوگر جدید گوگل فراهم می نماید. از سوی دیگر، مدیران سایت ها و وبلاگ نیز قادر خواهند بود تا پویا و زنده در نتایج جستجو سایت خود را به نمایش گذارند. از این امتیارات، کاربران و هم تولیدکنندگان محتوا نیز بی بهره نمی مانند و می توانند از این قابلیت استفاده کنند.

کمپانی گوگل الگوریتم کافئین را با الهام از ذهن انسان ساخته است که به دلیل سرعت بالایی که دارد به موتور جستجو این اجازه را می دهد تا جستجوی معنایی را در مقیاس بزرگتری بر عهده بگیرد. در واقع با گسترش اطلاعات موجود در شبکه جهانی، وجود این الگوریتم ضرورت یافته است. هدف گوگل از راه اندازی الگوریتم کافئین، حمایت از محتوای سایت میباشد.

کارایی الگوریتم کافئین گوگل:

این الگوریتم، یک پشتیبان بسیار مناسب برای محتوای وب سایت به حساب می آید. مهمترین ویژگی های این الگوریتم موارد زیر می باشد:

- سرعت به روزرسانی صفحات در الگوریتم کافئین بسیار زیاد می باشد و در هر ثانیه هزاران صفحه را به روزرسانی کرده و در نتیجه کاربر می تواند به جدیدترین و به روز ترین صفحات دسترسی پیدا کند.

- سرعت الگوریتم کافئین بسیار بالا است در نتیجه به گوگل کمک می کند تا جست و جوی معنایی در عبارات را در مقیاس های بزرگتر انجام دهد و در نتیجه نتایج بهتر و بیشتری را در اختیار کاربران قرار دهد.

الگوریتم گورخر گوگل (Zebra algorithm):

این الگوریتم جهت کیفیت سنجی فروشگاه های اینترنتی طراحی و اجرا شد و پس از آن فروشگاه های اینترنتی بی کیفیت و تقلبی از دور رتبه بندی در موتورهای جستجو خارج شدند. طراحی سایت به صورت واکنشگرا (ریسپانسیو)، داشتن بارکد برای تمامی کالاها، استفاده از کوپن های تخفیف برای تشویق کاربران به خرید این محصولات، ایجادمقایسه با کالاهای موجود در سایت های دیگر، کم شدن مراحل خرید و راحتی خریدار، وجود قیمت روی کالاها، وجود آدرس معتبر برای فروشگاه و … عواملی هستند که گوگل در این الگوریتم خود به آنها توجه می کند.

الگوریتم موش کور گوگل (Possum algorithm):

در بهینه سازی و سئو سایت، وبمسترها باید از اصول سئو استفاده کنند تا هم فعالیت آن ها قانونی باشد و هم تاثیر آن فعالیت ها بر رتبه بندی سایتشان، ماندگار باشد. گوگل نوعی از سئو را معرفی نمود که به کاربر این اجازه را می دهد تا بتواند موضوعات و کسب و کارهای مورد نظر خود را در موقعیت مکانی نزدیک به خود پیدا کند که به آن سئو محلی یا لوکال سئو (Local SEO) می گویند. این الگوریتم هم برای وبمسترها و هم برای کاربران بسیار شگفت انگیز و عالی بود.

گوگل برای بررسی سایت ها، از الگوریتم های مختلفی استفاده می کند که مهمترین هدف این الگوریتم ها، رعایت اصول سئو در سایت ها است. از این رو، گوگل برای سئو محلی الگوریتمی به نام الگوریتم موش کور یا الگوریتم Possum طراحی نموده که در سال ۲۰۱۶، آخرین به روز رسانی آن انجام شد. با استفاده از الگوریتم موش کور، گوگل نتایج متنوعی را بر اساس موقعیت فیزیکی جستجوگر ارائه می کند (هرچه شما به یک کسب و کار به صورت فیزیکی نزدیک تر باشید، بیشتر احتمال دارد که آن را در میان نتایج محلی و نتایج جستجویتان مشاهده کنید).

الگوریتم هاوک یا الگوریتم شاهین گوگل (Hawk algorithm):

در واقع الگوریتم هاوک یا الگوریتم شاهین گوگل برای اصلاح مشکلات به وجود آمده از الگوریتم Possum روی کار آمد.

زمانی که گوگل الگوریتم جدیدی را ارائه می کند کاملا انکار می کند که تغییر بزرگی به وجود آمده و ادعا می کند که روزانه به روزرسانی های زیادی را انجام می دهد و این الگوریتم ها دائما در حال به روز رسانی می باشند و هیچ الگوریتمی نسبت به الگوریتم قبلی دارای مزیتی نیست.

طبیعتا بسیاری از کسانی که توسط الگوریتم Possum فیلتر شده اند را الگوریتم هاوک نتوانسته در جستجو ها نشان دهد و این مشکل هنوز حل نشده است و تنها کاری که توانسته انجام دهد این است که اگر دو کمپانی که در فاصله کمی از هم قرار دارند و لوکیشن آنها به صورت مجزا می باشد را نشان دهد. همچنین این الگوریتم نتوانسته دو کمپانی که در یک ساختمان می باشد را از فیلترینگ در آورد.

الگوریتم موبایل گدون گوگل (Mobilegeddon algorithm):

از آنجایی که امروزه استفاده کاربری و کاربردی از موبایل و تبلت و استفاده ی کاربران آنها از اینترنت رو به افزایش می باشد، گوگل در راستای تقویت ابزار موبایل و تبلت، تصمیم به ارائه این الگوریتم گرفت و شرایطی را که بر اساس آن یک وب سایت به عنوان Mobile Friendly معرفی می شود.

این الگوریتم جزء جدیدترین الگوریتم های گوگل به حساب می آید که به تازگی اعمال گردیده است. سایت هایی که در صفحات تبلت و گوشی های همراه به خوبی نمایش داده نمی شوند به تدریج از نتایج جستجو حذف خواهند شد. یکی از راه هایی که سایت را منطبق با صفحه نمایش موبایل ها و تبلت ها طراحی کنیم استفاده از بوت استرپ است.

نکته مثبتی که در این الگوریتم وجود دارد،Real Time (بروز رسان) بودن آن است و این بدان معناست که اگر طراح وب سایت اقدام به ایجاد تغییرات در راستای همخوانی با موبایل در وب سایت خود کند، رتبه آن سایت بهبود خواهد یافت.

وجود این اتفاق، بسیاری از وب سایت های بزرگ دنیا را با یک چالش اساسی مواجه کرد و باعث شد که آنها به این الگوریتم جدید لقب “موبایل گدون” که برگرفته از آرماگدون می باشد را بدهند.

باید ها و نباید های الگوریتم Mobilegeddon:

- طراحی سایت به صورت ریسپانسیو یا واکنشگرا باشد.

- عدم استفاده از ابزارهایی که برای موبایل و تبلت اهمیت و عمومیت ندارد (مثل استفاده از Flash).

- استفاده از متن به نوعی که نیاز به بزرگ نمایی نداشته و قابل خواندن باشد.

- قراردادن لینک ها با فاصله معقول به صورتی که کاربر به راحتی بتواند لینک مورد نظر خود را انتخاب کند.

- استفاده از ابعاد مناسب جهت همخوانی با صفحه نمایش موبایل کاربر تا نیازی به بزرگ نمایی صفحه وجود نداشته باشد.

- ربات گوگل باید قابلیت دسترسی صد درصدی به فایل های css و js شما داشته باشد.

نکته بسیار مهم:

برای مقابله با این الگوریتم به هیچ وجه از نسخه موبایل به جای قالب واکنشگرا برای وب سایت خود استفاده نکنید. طراحان زیادی هستند که نمی خواهند نسخه اصلی سایت خود را تغییر و به قالب واکنشگرا تبدیل کنند و به جای آن، تصمیم به طراحی نسخه موبایل می گیرند و کاربران را به زیردامنه سایت خود منتقل می کنند. استفاده از این روش مشکلات زیادی را به همراه خواهد داشت که اولین و اصلی ترین مشکل، Duplicate Content است که از نظر گوگل اهمیت بسیار زیادی را داشته و مشکلات زیادی را برای وب سایت شما به همراه خواهد داشت.

الگوریتم فرد گوگل (Fred algorithm):

در هشت مارس ۲۰۱۷، گوگل، الگوریتم تایید نشده ای را به جریان انداخت که توسط کارشناسان فرد نامیده شد. واکنش ها به این الگوریتم نیز بسیار سریع و شدید بود. طبق گزارش ها سایت هایی که تحت تاثیر این الگوریتم قرار گرفتند، تقریبا ۹۰ درصد ترافیک خود را از دست دادند. بسیاری از سئوکار ها نیز دچار وحشت شده و دست به اقداماتی مانند پاک کردن بعضی از محتوا ها کردند، به این امید که رتبه سایت آنها باز گردد. این الگوریتم به منظور مقابله با محتواهای تبلیغاتی و غیر مفید ایجاد شد.

انواع سایت هایی که تاکنون تحت تاثیر الگوریتم Fred قرار گرفته اند:

- سایت های دارای محتوای بی ارزش و سطحی

- سایت های دارای تبلیغات بسیار زیاد

- سایت های به شدت وابسته مانند آمازون

- بعضی از سایت های کسب و کار محلی

الگوریتم هیلتاپ گوگل (Hilltop algorithm):

این الگوریتم بر روی یک شاخص خاص از اسنادهای متخصص به اجرا در می آید. این ها صفحاتی پیرامون یک موضوع خاص هستند و لینک هایی را به صفحات غیر وابسته دیگری مرتبط با آن موضوع دارند. نتایج بر اساس یک تطابق رتبه بندی می شوند. در واقع این الگوریتم بین صفحات «متخصص» و «معتبر» ارتباط برقرار می کند. یک صفحه تخصصی، صفحه ای است که لینک های بسیاری از اسناد دیگر و البته مرتبط، به آن پیوند داده میشوند.

از طرفی یک صفحه معتبر و مقتدر نیز صفحه ای است که درمورد یک موضوع خاص صحبت می کند و به بسیاری از صفحات غیر وابسته ای که بدان موضوع مرتبط هستند لینک می دهد، در واقع به صورت یک مرجع شناخته می شود. اگر یک وب سایت به صفحات متخصص لینک دهد، یک مقتدر یا معتبر یا همان مرجع خواهد شد.

در تئوری، گوگل در ابتدا صفحات متخصص را پیدا می کند و پس از آن صفحاتی که به آن لینک داده اند به رتبه خوبی خواهند رسید، به این معنی که در نمایش نتایج موتورهای جستجو اولویت با صفحه متخصص و پس از آن صفحات لینک داده شده است. صفحات در سایت هایی مانند یاهو، DMOZ یا سایت های دانشگاهی و کتابخانه ای معمولاً صفحات متخصص در نظر گرفته می شوند.

در ابتدا هدف اصلی الگوریتم هیلتاپ شناسایی سایت های مرجع و دایرکتوری های معتبر برای معرفی سایت ها در حوزه های گوناگون بود. گوگل این سایت ها را بررسی کرده و ارزش و اعتبار آنها را مشخص می نمود. بعد از تایید یک سایت به عنوان مرجع معتبر صفحاتی که در آن معرفی شده بودند، شانس زیادی برای کسب جایگاه در نتایج گوگل داشتند.

همین مسئله موجب شد که در آن سال ها دایرکتوری های معتبر مانند Dmoz، Yahoo و Wikipedia ارزشمندترین فضاها برای لینک سازی سایت های کوچکتر باشند. به کمک الگوریتم هیلتاپ، گوگل می توانست سایت های مرجع را شناسایی کرده و از طریق آنها سایت های معتبر را پیدا کند.

مشخصا الگوریتم هیلتاپ یکی از قدیمی ترین الگوریتم های گوگل است، اما داشتن آگاهی از الگوریتم هیلتاپ حتی به عنوان یک الگوریتم بسیار قدیمی می تواند رفتار امروزی سئو را توضیح داده و به عنوان دانش پایه ای و اساسی برای فهم سئوی مدرن به کار گرفته شود.

الگوریتم پیج اتوریتی (Page Authority):

الگوریتم پیج اتوریتی (Page Authority) به معنای قدرت صفحه می باشد و با استفاده از فاکتور های مختلفی نظیر کیفیت محتوا، میزان لینک های ورودی از سایت های دیگر، تعداد بازدید کننده و زمانی که بازدیدکننده ها در سایت شما می گذرانند، میزان قدرت صفحه وب سایت مشخص شده و در رتبه آن در گوگل تاثیرگذار است. این الگوریتم شبیه همان پیج رنک گوگل است با این تفاوت که امتیاز دهی به فاکتور های ذکر شده توسط سایت MOZ صورت می پذیرد.